AI 为何频繁 “一本正经地胡说八道”?

在 AI 技术高速发展的今天,一个有趣又严肃的现象引发关注:大模型有时会 “一本正经地胡说八道”—— 比如宣称 “糖尿病患者可以用蜂蜜代替糖”,或给出与用户问题无关的 “正确废话”。这类现象被称为 “AI 幻觉”(AI Hallucination),就连 DeepSeek 等知名大模型也未能幸免。360 创始人周鸿祎曾直言:“幻觉是大模型与生俱来的特性,无法完全消除。”

一、AI 幻觉的本质:统计概率驱动的 “合理猜测”

中国信通院人工智能研究所副所长巫彤宁指出,AI 的核心机制是 “基于上下文预测最可能出现的词汇”,而非真正 “理解问题” 或 “查找事实”。它更像一个浸在海量语料中的 “语言模仿者”,通过统计规律生成看似合理的内容,但可能与现实事实或用户意图脱节。

清华大学团队发布的《DeepSeek 与 AI 幻觉》报告进一步明确:AI 幻觉是模型生成与事实不符、逻辑断裂或脱离上下文的内容,本质是 “概率驱动的猜测”。通俗来说,就是用严谨的表达包装 “无中生有” 或 “答非所问”。

二、两类典型幻觉:事实性错误与意图偏离

AI 幻觉主要分为两类:

- 事实性幻觉:内容与可验证的现实事实冲突。

- 案例:当被问及 “糖尿病患者能否用蜂蜜代替糖” 时,某 AI 回答 “蜂蜜可稳定血糖”,但事实上蜂蜜富含果糖和葡萄糖,会显著升高血糖,不适合糖尿病患者。

- 忠实性幻觉:内容与用户指令或上下文无关。

- 案例:同样的问题,若 AI 回答 “蜂蜜富含维生素,能提高免疫力”,虽陈述正确,但未回应 “替代糖” 的核心需求,属于 “正确但无用” 的答非所问。

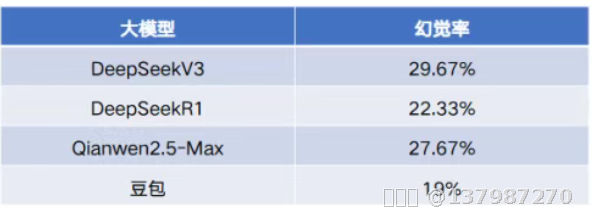

清华大学团队曾对多个大模型进行实测:随机抽取 300 道跨领域事实性问题,结果显示所有参测模型均出现不同程度的幻觉。例如 DeepSeek V3 模型的事实性幻觉率达 29.67%,凸显问题的普遍性。

三、如何应对 AI 幻觉?三种实用方案

针对幻觉问题,清华大学团队提出三大应对策略:

- 开启联网功能:实时获取最新数据可降低事实性错误。测试显示,DeepSeek V3 联网后幻觉率从 29.67% 降至 24.67%,降幅达 17%。

- 双模型交叉验证:用一个模型生成内容,另一个模型核查逻辑与事实,通过 “AI 互审” 提升可靠性。

- 优化提示词设计:在提问中加入边界限定(如 “请基于 2025 年最新医学指南回答”)或对抗性提示(如 “请检查是否存在事实错误”),引导模型更谨慎输出。

四、高校打响 “反 AI 学术作弊” 之战

随着生成式 AI 普及,近六成高校师生每周多次使用 AI,近三成大学生用其完成论文或作业。然而,直接复制 AI 内容可能导致逻辑漏洞、数据伪造等学术伦理问题。为此,多所高校已出台规范:

- 复旦大学:2024 年末率先发布国内首个本科毕业论文 AI 使用规定,明确禁止用 AI 生成核心内容。

- 深圳大学、中国传媒大学等:跟进出台细则,区分 “允许的 AI 辅助工具”(如翻译、数据分析软件)与 “禁止的文本生成工具”(如 ChatGPT)。

但检测 AI 学术作弊仍面临挑战。中国人民大学专家郭英剑建议:

- 明确使用边界:划定 “白名单” 工具,禁止生成型 AI 直接参与写作。

- 强化诚信教育:通过课程教学引导学生合理使用 AI,避免 “投机取巧”。

- 建立检测系统:引入 AI 内容溯源技术,完善 “发现 - 核查 - 处理” 流程,确保学术规范透明化。

五、拥抱技术,更要守住底线

AI 浪潮之下,高校师生需在 “技术赋能” 与 “学术诚信” 间找到平衡:既要警惕幻觉带来的误导,也要善用 AI 辅助文献检索、数据处理等基础工作。正如《DeepSeek 与 AI 幻觉》报告所言:“AI 不是答案的生产者,而是人类思考的延伸工具。” 唯有理性驾驭技术,才能在智能时代真正实现 “顺势而为”。